Será que a Inteligência Artificial (IA) pode ser aplicada a tudo? Ora, a Microsoft quer criar uma para “prestar cuidados emocionais”, isto é, de alguma forma, servir de psicóloga.

As patentes nem sempre resultam em produtos ou serviços concretos – sabemo-lo bem. No entanto, é verdadeiramente curioso perceber, através delas, aqueles que poderão ser os planos das empresas. Às gigantes tecnológicas, por exemplo, ideias não faltam.

A Microsoft, especificamente, registou, agora, um pedido de patente para uma aplicação, alimentada por IA, destinada a oferecer tratamento psicológico.

O chatbot de Inteligência Artificial está a tornar-se cada vez mais popular e a ser aplicado num número crescente de cenários.

Escreveu a Microsoft, num documento, apresentado no dia 7 de novembro, nos Estados Unidos da América.

Consultas de psicologia dadas por IA?

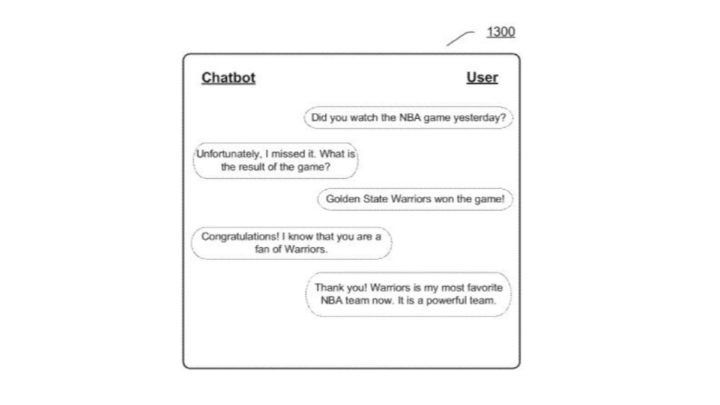

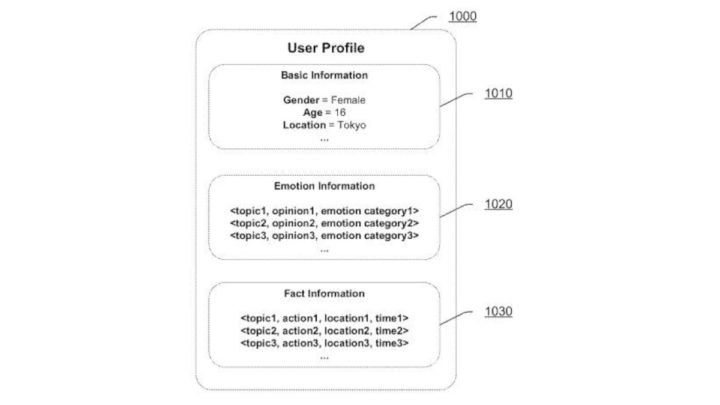

A empresa pretende que a sua terapeuta artificial forneça “cuidados emocionais” através de uma conversa simulada, na qual os utilizadores podem utilizar texto, voz e imagens.

Além disso, conforme explicado, a aplicação terá uma janela de conversação, um módulo de processamento e uma base de dados de respostas. A partir daí, o sistema será capaz de conduzir testes psicológicos explícitos, fazer perguntas e monitorizar as respostas.

Por ser alimentado por um sistema de IA, vai utilizar as respostas para aprender com os pacientes.

A psicóloga artificial avaliará os utilizadores, por via de um “algoritmo de pontuação predefinido por psicólogos ou especialistas”. Nalguns casos, o chatbot poderá até fazer sugestões sobre a forma de resolver determinados problemas.

A patente da Microsoft surge, apesar do aviso que a Organização Mundial de Saúde (OMS) fez, na sequência do aparecimento do ChatGPT.

A organização alertou para a necessidade de ter atenção ao uso de chatbots de IA nos cuidados de saúde, uma vez que os dados utilizados para treinar estes modelos podem ser “tendenciosos” e gerar informações enganosas que podem causar danos aos pacientes.

Trata-se apenas de uma patente, mas, a ser verdade, deixar-se-ia ajudar por um psicólogo artificial, alimentado por IA?

Deixe um comentário